OpenAI Devdayでの発表、何が嬉しいのかAIエンジニアが解説します

OpenAIは2023年11月6日に同社の企画するイベントであるDevDayで製品アップデートに関する発表を行いました。

開発者向けのイベントであったため、これまでにOpenAIの提供してきた機能をガッツリ使っていないと、何が嬉しいのかがわかりにくいという側面がありました。

本記事ではAI開発を専門とする技術コンサルタントの筆者が、OpenAIが公開したアップデートの内容を解説し、今後どのような影響がでるのかについて知見を共有したいと思います。

複数の情報が公開されましたが、前半に用途が明確なもの、後半では概念的なものという順番でご紹介いたします。

目次

GPT-4 Turbo

2023年3月にGPT-4が公開されましたが、今回の発表では新しいモデルのプレビュー版であるGPT-4 Turboが発表されました。

名前の通り、テキストの生成速度がググッと向上しています。

また、知識が2023年4月までの情報にアップデートされました。

ただし、知識に対するQAに関してはRAGを用いた構成が推奨されるため、知識を問いかける使い方はこれまでと同様に非推奨となります

一番特筆すべきポイントですが、このモデルでは128kのトークンという長い情報を扱うことができます。

また、料金についてはGPT-4と比較して入力トークンで3倍、出力トークンで2倍安くなっています。

このモデルはOpenAIのAPIで`gpt-4-1106-preview`と指定すると使用することができます。

以下では長いテキストデータが活用できることでどのようなメリットがあるのか紹介します。

要約タスクの実装が簡単になった

128kというの長いテキスト情報を一括で扱うことができるようになったため、要約を行うことが簡単になりました。

従来ではヒューリスティクスが使えない場面でナイーブな実装を行う場合には、以下のような手順で要約を行う必要がありました。

- 文書を渡した後に3,000トークン毎に分割しチャンクを作成(仮にA, B, Cのグループに分割したとする)

- A, B, Cのすべてのチャンクの中で要約を実行

- A, B, Cそれぞれの要約を結合し、その文章に対して要約を実行

→ ただし3.で結合したときにトークン上限数を超えるようであれば1の手順から行う

今回発表されたGPT-4 turboでは、理想的には128kトークンまでのテキストであればプロンプト設計だけに集中すればよくなりますので、開発者にとってはなかなか嬉しい機能となっています(もちろん要約能力の検証を行う必要はありますが)。

コーディング支援ツールもより賢く

自前でコーディング支援ツールを作成している人は少ないかもしれませんが、プログラマーは自然と恩恵を受ける可能性があります。

Copilotを代表としたコーディング支援ツールでは、例えばある関数を作りたいときに、プロジェクト内の文脈(他のソースコード)を把握できるほどユーザの意図する機能を自動生成することができるようになります。

これまでと比較してかなり長いテキストを文脈として把握することができるため、複雑な実装なしにより賢いツールにできることが期待されます。

ちなみにDevDayのデモで使用されていたエディタはCursorと呼ばれるAIエディタです。

CopilotなどのAIとコラボしたコーディングを試したことがない人は是非使ってみてください。

GPT-4のファインチューニング

これまでにGPT-3.5のファインチューニングが公開されてきましたが、GPT-4のファインチューニングについても近い将来に公開されることが発表されました。

発表時点では公開されていませんが、ウィッシュリストが公開されていますので、興味のある方はいち早く登録を行うことをオススメします。

GPT-3.5のファインチューニングの紹介については以下の記事で行っていますので、参考にしていただければ幸いです。

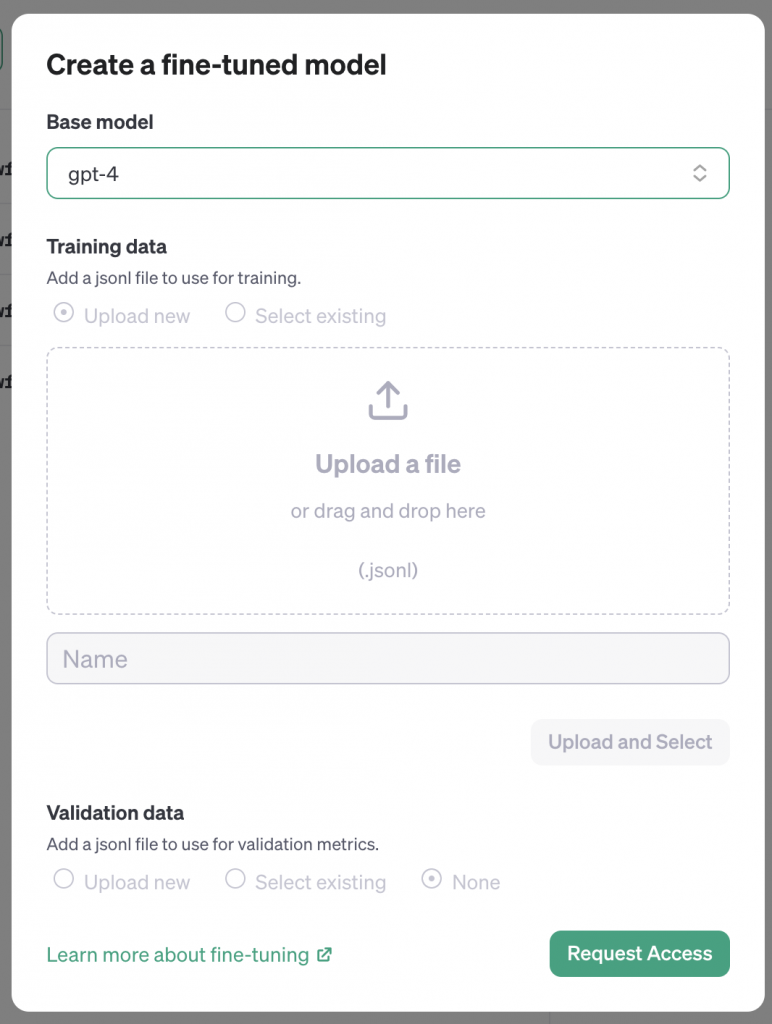

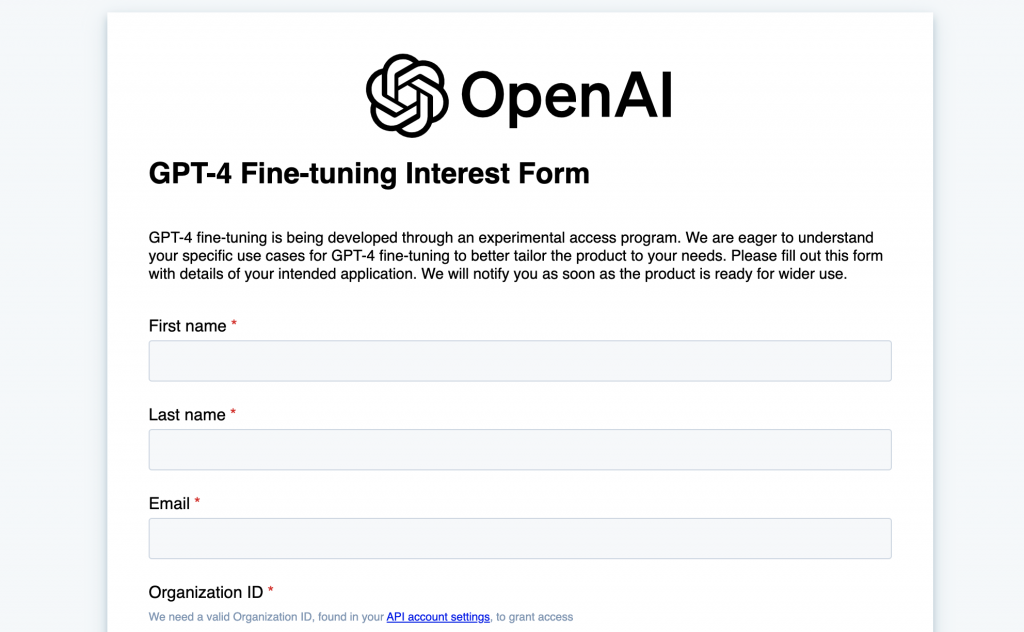

ウィッシュリストに登録する方法

- PlayGroundのfine-tuningに移動する

https://platform.openai.com/finetune - Create Newをクリック

- Base Modelでgpt-4を選択する

- 右下に緑色でRequest Accessというボタンが出るのでクリック

※アカウントによってはまだ選択できないようです、私の周囲ではすでにファインチューニングの使用実績があったりGPTの使用料金が多い人ほど公開されている傾向にあります。

GPT-4 Turbo with Vision

これまではWeb版のChatGPTのみでしか提供されていませんでしたが、APIからも使用できるようになりました。

使用するモデルにmodelに`gpt-4-vision-preview`を指定するとAPIを通して活用することができます。

いくつかの注意点がOpenAIから提示されており、以下のようになります。

- 医療場面で使用しないこと(CT画像など)

- 英語以外が弱い

- 大きなテキストがある画像

- 画像が回転している状態のもの(上下逆さまなど)

- チェスの駒が置いてあるマスなどの微細な空間推論

- 間違った画像説明をしてしまうことがある

- パノラマ画像や魚眼レンズのような画像

- オブジェクトのカウント

- CAPTCHAS(ログインなどによくある認証のこと、セキュリティ的な観点から対応できない)

読み込める資料の種類が増える

これまではChatGPTはテキストを中心に読み込んでいましたが、画像を読み込めるようになったため、より幅広い範囲でのドキュメントに目を通すことができるようになりました。

例えばインフラ構成図をパワポで作成し、GPT-4 Visionで読み込み、terraform(IaC)で処理できる形に翻訳することで、一発で仕様書からインフラを構築することができるようになるかもしれません。

他にも、例えばSIerではRDBに関する仕様を記述するときにER図を作成してきていましたが、これからは人手をほぼ介さずにER図からデータベース群の立ち上げを行うことができるようになるかもしれません。

SQLクエリでスキームを定義する手間が省けると嬉しいですね。

JSON mode

GPTの出力をそのまま後続の処理に回したい場面は多々ありますが、GPTの出力フォーマットが自由だと扱いが困難なケースがありました。

これからはAPIのパラメータで`response_format={ “type”: “json_object” }` と指示するとJSON形式で応答が返ってくるように限定できるようになりました。

JSONパース周辺の処理を実装する必要がなくなる

例えば有価証券報告書から情報を抽出し正規化する、というような場面でGPTを使用してJSON形式に変換するニーズがありました。

これまではプロンプトの中で、1.JSONで出力すること、2.JSONのフィールド情報を与えること、の2つを行うことでGPTの出力をJSONにすることができる、と思いきや、GPTの出力が「以下が◯◯の結果です」といった出力を行ってしまう場面が少なからずあり、温度パラメータを0.1~0.2ほどに設定し、JSONパースできない場合はリトライする、といった煩雑な処理を行う必要があり、地味に面倒なものでした。

(余談かつ経験的な話で恐縮ですが、医療や金融などの専門的な話題になるほど、JSON以外の前置きを出力してしまう傾向が高かったように思えます。)

今回の発表でOpenAI側でJSON形式を確約する宣言がなされたことで、かなりストレスフリーな開発が行えるようになります。

他のコンテンツと比べると地味なアップデートですが、筆者としてはかなり嬉しいアップデートでした。

GPTs / GPT Store

用途特化型のオリジナルのChatGPTを作成することができるようになりました。

ノーコードどころかChatGPTと対話を行いながらオリジナルのChatGPTを作成することもでき、それを専用のプラットフォームであるGPT Storeで公開することも近い将来にはできるようです。

人物やキャラクターを模したチャットボットだったり雑学botのようなものをサクッと作成し、公開できるようになりそうです。

他にもGPT-4 Visionと連携し、教科書をスマホでパシャっと撮ってアップロードしたら、小学生向けに算数の問題の解き方を教えてくれるような家庭教師botなども簡単に作れてしまうかもしれません。

利点が明確な一方で、現状だとエンジニアではない人が簡単なbotを作成できるようになっただけという印象もあり、大きな事業に直接結びつくようなものではないようにも見えます。

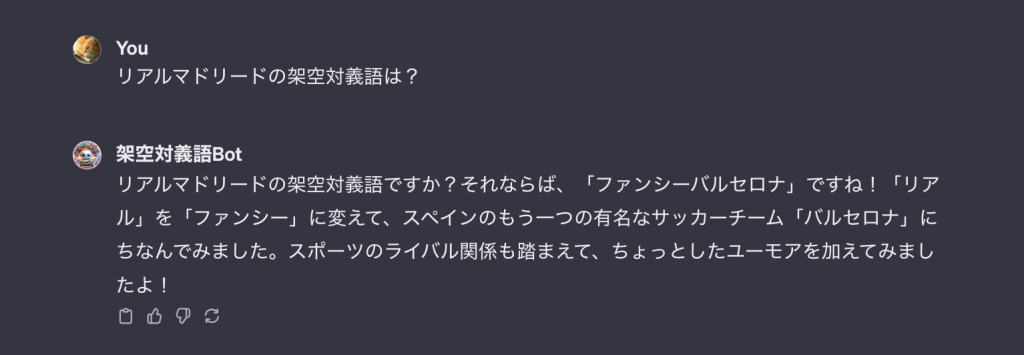

ちなみにですが、私も試しに架空対義語botを作成してみました。

ファンシーバルセロナ、なんだかハリーポッターに出てきそうな雰囲気になりました(悪くない出力だと思います)。

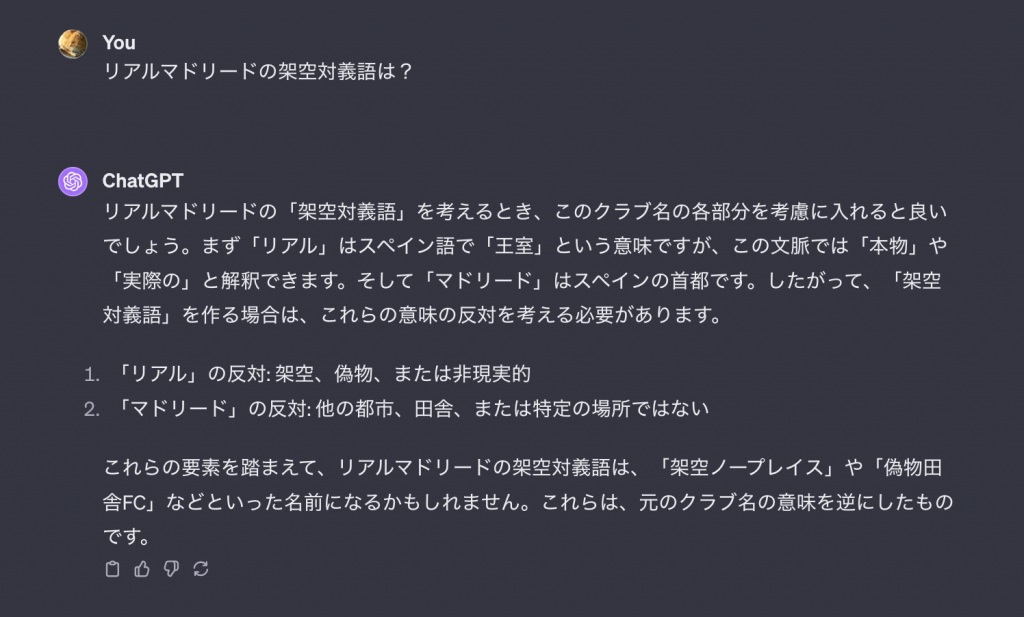

ちなみに、以下が素のChatGPTの結果になります。

特化型GPTの作成は難しいですが、しっかり差別化はできていそうです。

Assistants

Code Interpreterや外部知識の活用(RAG)、そしてFunction Callingを通した独自ツールへのアクセスなど、これらの要素に並列にアクセスできるようになりました。

これによって、開発者が自前で準備していたツールとの連携がより簡単になります。

できることの幅が爆発的に広がったため、一言で何が嬉しいかを表現することは難しいですが、例えばこれまでWeb版のChatGPTで行えたような、AIによるデータ分析を自らが作成するツールの中で動かすことも可能になります。

これに加えて、外部知識の使用も簡単になるため、例えば有価証券報告書データベースから決算情報を抽出し(RAG)、業界毎にグルーピングして成績を算出して比較(CodeInterpreter)することも容易にできるようになるかもしれません

OpenAI公式による紹介は以下に記載されています。

https://platform.openai.com/docs/assistants/how-it-works/creating-assistants

おわりに

Assistantsのような既存のGPTの枠を超えた提案が出てきたものの、langchainなどのサードパーティツールで積極的に取り組まれてきたような機能をOpenAI側が提供し始めてきただけという見方もあり、現時点では全く想定していなかった!というレベルの情報ではなかったように思えます、イノベーティブな製品を頻繁に公開されるとしんどいので助かる。

一方で、実装時の苦痛が和らぐようなアップデートが多かったため、開発者目線では嬉しいアップデートばかりでした。

GPT-4 VisionとGPTs, Assistantsに関してはポテンシャルをかなり秘めており、これらを有効活用したアプリには今後注目していきたいです。

特にGPT Storeが浸透した未来では、スマホにおけるiOSやAndroidのような立ち位置になっている可能性さえあります。

また、オウンドメディアを運営する身としては、将来のWebメディアのあり方についても考えてしまいます。

多数のオウンドメディア事業者がGPTsで特化型の情報提供チャットボットを構築するようになってきた場合、検索エンジンに向けたSEOだけでなくGPT Store内における検索最適化が着目されるなど、エコシステムが一変する可能性も否定できません。

AIReview(エアレビュー)では引き続きOpenAI関連の情報を提供してまいりますので、引き続きよろしくお願いいたします。

また、ChatGPTを使用した開発やコンサルティングのご依頼も受け付けております。

AI開発に関する顧問サービス以外にも、業界特化の相談チャットボットの開発、GPTを活用した既存プロダクトの拡張機能の開発なども沢山行っており、実績も豊富ですのでお困りの際にはお声がけいただければ幸いです